Presentazione di informazioni nel computer

Vi siete mai chiesti che cosa è comune tra le persone antichi, gli esseri umani moderni e computer? Nonostante le differenze, il totale è ancora lì. Pitture rupestri dell'uomo primitivo, la registrazione dei nostri contemporanei e codice binario nei computer – tutti i modi di presentare le informazioni, o, più precisamente, solo alcune delle loro specie. Ora, quando i computer sono diventati parte della vita quotidiana della società, tutti, per stare al passo con i tempi, è necessario comprendere almeno i termini e concetti di base.

Dal suo inizio, sistemi di computer hanno sostituito diverse generazioni: prima era una macchina di aggiunta meccanica, allora il modello lampada e, infine, il semiconduttore varietà elettronici. Ciò che è interessante, fin dai tempi antichi, quando era l'inizio del computing, i principi fondamentali della codifica dei dati sono rimasti invariati. In altre parole, la fornitura di informazioni nel computer è la stessa in dispositivi meccanici. Naturalmente, stiamo parlando di principi, non i metodi di attuazione. Tutti sanno che la presentazione delle informazioni nel computer ha una natura binaria. Questo è stato detto nelle prime lezioni di informatica a scuola. Cosa si nasconde dietro il termine "calcolo binario"?

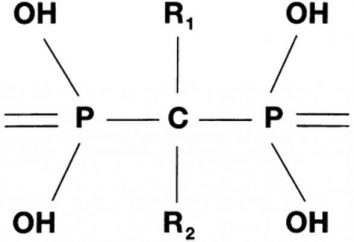

Cerchiamo di contare fino a dieci: 0, 1, 2, 3, 4 … 10. In questa serie di dieci cifre, con se stesso "10" – è assente, perché è costituito da due semplici "1" e "0". Presentazione di informazioni a un altro computer. Si utilizza solo le prime due cifre, e non solo la loro immagine, e scosse elettriche: il transistor, questo "mattone" di circuiti elettronici moderni, può avere due posizioni – chiuso e aperto. Quando alimentato alla sua tensione base cut-off (prelievo, un'unità logica), quindi l'elemento conduce nessuna corrente, e viceversa. Ovviamente, in pratica, la fornitura di informazioni nel computer è implementata su meccanismi più sofisticati, "1" può significare sia la presenza e l'assenza di un segnale. Quest'ultimo non solo controlla lo stato di un singolo transistore e genera un'operazione logica "AND – OR".

Logico "0" e "1" sono chiamati bit (cifra binaria – cifra binaria, figura). Un gruppo di bit di otto (non dieci!) È un byte. Combinando la loro sequenza in grado di codificare qualsiasi carattere. Di conseguenza, il byte – la più piccola unità di informazione. A sua volta, cambiando l'ordine dei byte possono essere codificati (rappresentato in forma digitale) con qualsiasi informazione. Tale codifica viene eseguita da dispositivi separati, e programmi per computer. Ad esempio, quando diciamo "a Skype" attraverso un microfono, un segnale elettrico analogico (onda) viene convertito in una scheda audio di zeri logici e quelli corrente che passava alla sorgente di programma, in cui la trasformazione inversa – un'onda viene inviato alla sorgente sonora. Allo stesso modo, premendo un tasto qualsiasi della tastiera, l'utente indica al programma di codice binario desiderato, ma per la comodità del carattere desiderato viene visualizzato sullo schermo.

Modi di presentare le informazioni in un computer, come già accennato, permette di codificare tutti. Ad esempio, per digitalizzare immagini applicata la seguente soluzione: poiché qualsiasi immagine può essere rappresentato come un insieme di punti, ciascuno dei quali è caratterizzato dalle coordinate sul piano, luminosità, colore, è sufficiente ruotare tutti questi dati in un computer sequenza comprensibile di uno e zero. Accanto a visualizzare una copia del messaggio su schermo del monitor programma invia al informazioni dispositivo di uscita per ogni punto, e in conformità con la sua immagine è costruito.

Il vantaggio del sistema binario di calcolo per l'altro è la sua semplicità e praticità di "legare" la gestione di chiavi elettroniche. E 'in parte questo è stato il motivo principale per il suo utilizzo nei moderni sistemi informatici.